Fra Big Data e ChatGPT: nuovi rischi sulla privacy e nuove responsabilità per i Data Protection Officer

Nel 2008 Chris Anderson, l’allora direttore di Wired, scrisse un articolo intitolato “The End of Theory : The Data Deluge Makes the Scientific Method Obsolete”, che diede luogo a molte discussioni su questa fine, generata dai big data il cui sfruttamento avrebbe consentito di mettere da parte la ricerca basata sul metodo scientifico. La correlazione statistica viene celebrata come specchio della realtà, senza bisogno di alcun tipo di mediazione teorico-interpretativa per leggere i dati. Insomma: la morte della teoria, dell'interpretazione.

Con implicazioni in termini di trattamento dei dati personali la cui raccolta e trattamento dovrebbero essere lecitamente autorizzate dagli interessati a cui dovrebbe essere resa chiara la posta in gioco (con buona pace di cookie più o meno obbligatori ed evidenti). In caso contrario, lo scenario diventa quello del capitalismo della sorveglianza ben descritto e denunziato da Shoshana Zuboff.

Ma, aldilà del fatto che i numeri possono spiegare ciò che esiste – dalla media alle code eccentriche - non la varianza futura, numerosi poi sono i stati i cigni neri che da quella data hanno solcato i nostri cieli, per eventi che ancora condizionano il nostro futuro: e la correlazione nulla ha potuto se non per prevederle comunque per mettere sul chi va là i diversi soggetti coinvolti.

Diminuita (almeno parzialmente) la forza euristica della correlazione by big data, il metodo scientifico seppur riabilitato – e sicuramente consapevole dell’importanza che hanno e avranno i big data - comunque deve far fronte a nuovi pericoli e assalti, e noi con lui, perché nuove questioni si sono rapidamente imposte sullo scenario.

In primo luogo, pian piano con lo sviluppo anche dei social, si è diffusa nel primo scorcio di questo millennio prima la “truthiness”, la verità intuitiva, superata poi dall’arma delle fake news – esemplificativi i proclami no-vax basati su supposti fondamenti scientifici – sicchè oggi siamo nel pieno di ondate di post-verità, andando però molto oltre l’affermazione sulla fine della teoria di Friedrich Nietzsche che con l’affermazione “non esistono fatti, solo interpretazioni” piuttosto voleva forse rendere palese come la verità sia una costruzione sociale. Inoltre, utilizzare illecitamente profili e caratteristiche delle persone per trasmettere messaggi mirati per influenzare le loro intenzioni e comportamenti se pur non si traduce in fake news quantomeno impatta sulla libertà di pensiero e sulla tutela dei dati personali (e qui vien subito alla mente il caso di Cambridge Analytica).

Riassumendo: la forza della correlazione, dell’oggettività estratta dai dati si è un po' indebolita, ma il metodo scientifico non ha ripreso la sua centralità, perché le fake news colpiscono anche l’evidenza scientifica, che si basa sulla formulazione di ipotesi a partire da osservazioni e sulla costruzione di teorie che vengono confermate o falsificate dalle evidenze empiriche.

A rendere più complicata la questione, a indebolire la forza esplicativa della correlazione, dell’oggettività estratta dai dati à la Anderson va anche aggiunto che se è vero i dati, i big data sono tanti, comunque rappresentano le diverse caratteristiche di una parte della realtà – a meno di non ammettere che da qualche parte in database immensi (e consumatori di enormi quantità di energia), in qualche cloud lontano ci siano i dati che al 100% ci rappresentano: ma è proprio scambiando la parte per il tutto che spesso si generano distorsioni.

Ma qualcosa di nuovo è all’orizzonte: ChatGPT (una chatbox conversazionale ad apprendimento, per quanto noto, automatico ma anche supervisionato e per rinforzo) sviluppata da OpenAI , in grado di conversare e fornire risposte articolate (un tool collegato crea anche foto e disegni sulla base di poche indicazioni). Attualmente molto se ne discute ed è in preparazione una versione più avanzata di quella attuale, che riesce a processare informazioni sino (per l’intanto) al 2021. Presso la scuola di giornalismo della LUISS l’hanno sperimentata pubblicando un intero numero della loro rivista ZETA tramite ChatGPT sotto la supervisione degli studenti. In questi giorni, in alcuni momenti, è talmente ricercato da non poter processare tutte gli accessi e le richieste. Ma non è un gioco: oltre alla osservazione che il progetto viene oggi valutato 29 miliardi di dollari - quindi è una bellezza di business! - quanto ora noto genere dubbi e cautele dal punto di vista del trattamento dei dati personali, basti far riferimento alle osservazioni di Guido Scorza , disponibili sul portale del Garante della privacy: “per accedere al servizio è indispensabile lasciare un indirizzo e-mail e attivare un account ed è altrettanto certo che il servizio archivia la cronologia delle nostre domande. Insomma, qualcuno, qualcosa su di noi, la mette da parte per certo”.

Di fronte al nuovo scenario che si va aprendo, occorre che i diversi attori pubblici e privati facciano la loro parte per governare lo sviluppo dell’intelligenza artificiale e l’impatto sulla società. Certo cambieranno molti processi di lavoro e molte professioni verranno sostituite dall’IT. Il professor Luciano Floridi, intervistato sulla questione ha affermato “ChatGPT non deve essere bandita dalle scuole, ma insegnata. Nelle scuole si dovrebbero dare gli strumenti per comprendere e usare queste tecnologie”. Se così non sarà è difficile dire quale possa essere il futuro di economie e società e culture. E quale possa essere il futuro della privacy.

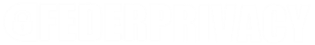

(La risposta alla domanda “Quali sono i rischi per la privacy delle persone connessi ai big data e a ChatGPT?” fornita dalla stessa ChatGPT in un test effettuato il 30.01.2023)

E qui, per quanto ChatGPT sia a uno stadio iniziale – così come analoghe tecnologie, ad esempio la cinese Baidu starebbe sviluppando un analogo sistema – fa riflettere quando, in risposta alla domanda “Quali sono i rischi per la privacy delle persone connessi ai big data e a ChatGPT?” risponde (successivamente la risposta potrebbe essere più fine in relazione al suo progressivo autoapprendimento…):

“I rischi per la privacy associati ai big data e ai modelli di lingua come ChatGPT includono:

1. Raccolta eccessiva di informazioni personali

2. Uso improprio delle informazioni raccolte

3. Intercettazioni o furto di informazioni personali da parte di terze parti

4. Profilazione invasiva basata sull’analisi dei dati

5. Discriminazione basata sull’analisi dei dati

È importante che le aziende che gestiscono questi dati e modelli adottino misure di sicurezza adeguate per proteggere la privacy dei loro utenti”.

Ci sarebbe da aggiungere: e che le Autorità pubbliche e di settore a livello macro e i Data Protection Officer come gli altri operatori privacy a livello micro, si approntino ad affrontare il futuro che già è qui.